Referensi: Mellatshahi, Navid et al. 2021. Inverted Pendulum Control with a Robotic Arm

using Deep Reinforcement Learning. International Symposium on Signal, Ciruits and System (ISSCS).

ISSCS: University of Windsor, ISBN: 978-1-6654-4942-7

Mengaktifkan sistem robot untuk tindakan otonom seperti sistem tanpa pengemudi, adalah tugas yang sangat kompleks dalam skenario dunia nyata karena ketidakpastian. Pembelajaran mesin kemampuan telah dengan cepat membuat jalan mereka ke sistem otonom dan teknologi robotika industri. Mereka menemukan banyak aplikasi di setiap sektor, termasuk kendaraan otonom, robot humanoid, drone, dan banyak lagi. Dalam penelitian ini kami akan mengimplementasikan kecerdasan buatan pada lengan robotik mampu memecahkan masalah kontrol keseimbangan yang kompleks dari awal, tanpa ada umpan balik dan menggunakan algoritma pembelajaran penguatan mendalam yang canggih bernama DQN.

Masalah patokan yang dianggap sebagai studi kasus, adalah keseimbangan terbalik pendulum ke atas menggunakan robot beroda dua. Bentuk yang sangat sederhana ini masalah telah dipecahkan baru-baru ini menggunakan pembelajaran mesin namun di bawah tesis ini kami membuat sistem pendulum terbalik yang sangat kompleks dan diimplementasikan di Robot Sistem Operasi (ROS) yang merupakan lingkungan simulasi yang sangat realistis.

Kami tidak hanya berhasil mengendalikan pendulum tetapi juga menambahkan turbulensi model yang dipelajari untuk mempelajari ketahanannya. Kami mengamati bagaimana model pembelajaran awal tidak stabil dengan adanya turbulensi dan bagaimana turbulensi acak membantu sistem untuk mengubah ke model yang lebih kuat. Kami juga telah menggunakan model yang kuat di lingkungan yang berbeda dan menunjukkan bagaimana model mengadopsi dirinya dengan fisik baru properti. Menggunakan sensor orientasi pada ujung pendulum terbalik untuk mendapatkan kecepatan sudut, simulasi di ROS dan pendulum terbalik pada ball joint sedikit disorot hal baru dalam tesis ini dibandingkan publikasi sebelumnya.

Kendali pendulum terbalik merupakan salah satu tolak ukur permasalahan kendali yang digunakan oleh para peneliti untuk menguji strategi kontrol baru selama 50 tahun terakhir. Ini memiliki struktur sederhana tetapi kaya model untuk menguji strategi pengendalian. Memecahkan jenis masalah ini dengan pembelajaran mesin adalah pendekatan yang menjanjikan karena tidak memerlukan model sistem yang dinamis melainkan algoritma pembelajaran mesin dapat menghasilkan tindakan otonom berdasarkan pengalaman.

Studi kasus yang dimaksud dalam tesis ini adalah menyeimbangkan pendulum terbalik pada ball joint menggunakan lengan robot dan teknik pembelajaran mesin alih-alih loop kontrol normal seperti PID. Pendulum terbalik dapat bebas jatuh ke segala arah karena terhubung ke end-effector menggunakan ball joint. Kami menggunakan Inertial Measurement Unit (IMU) untuk mendapatkan sudut kecepatan dan orientasi pendulum untuk menggunakan data ini dalam algoritma pembelajaran.

Kendali pendulum terbalik merupakan salah satu tolak ukur permasalahan kendali yang digunakan oleh para peneliti untuk menguji strategi kontrol baru selama 50 tahun terakhir. Ini memiliki struktur sederhana tetapi kaya model untuk menguji strategi pengendalian. Ada banyak aplikasi robot juga berdasarkan pendulum terbalik dalam hal prinsip stabilisasi mereka. [1] Misalnya:

• Kontrol sistem robot yang kurang digerakkan

• Desain pendulum terbalik bergerak

• Perencanaan kiprah robot humanoid

Kontrol robot humanoid adalah tugas yang menantang karena memiliki kendala dinamis dan ketakpastian. Pembuatan pola kiprah adalah masalah utama dan untuk menyederhanakan lintasan generasi banyak penelitian menggunakan analogi antara kiprah bipedal dan pendulum terbalik gerak[1]. Desain dan implementasi pendulum beroda bergerak muncul dalam produk komersial juga, Segway dan skuter self-balancing adalah dua contoh produk komersial itu menggunakan pendekatan pengontrol pendulum terbalik.

Mengaktifkan sistem robot untuk melakukan tugas secara mandiri adalah tugas yang sangat kompleks di dunia nyata skenario karena ketidakpastian. Ketidakpastian tidak dapat diprogram oleh IF & THEN, jadi semacam kecerdasan buatan umum yang diperlukan sistem ini untuk memungkinkannya dibuat keputusan seperti manusia.

Metodologi Penelitian[kembali]

Pendekatan kami untuk memecahkan masalah yang diusulkan adalah menggunakan pembelajaran penguatan keadaan seni algoritma di lingkungan Robot Operating System (ROS). Kami akan menggunakan pembelajaran penguatan (RL) untuk mengatasi tantangan pengumpulan data, karena pembelajaran penguatan tidak membutuhkan data apa pun untuk memecahkan masalah, melainkan itu belajar dengan teknik hadiah dan hukuman. Ada banyak pembelajaran penguatan algoritma, tetapi kami akan menggunakan Deep Quality Network (DQN) yang baru-baru ini menarik banyak aplikasi dan muncul dalam penelitian terbaru untuk berbagai jenis aplikasi di mana jenis keputusan manusia diperlukan. Kami akan menggunakan ROS dalam kombinasi dengan simulasi Gazebo yang sangat realistis lingkungan dan sangat digunakan dalam masalah komersial dan penelitian. Menggunakan realistis

lingkungan membantu pada waktu perhitungan dan mengatasi tantangan keselamatan. Keamanan adalah kuncinya masalah dalam pembelajaran penguatan karena agen atau robot tidak memiliki pemahaman apapun lingkungannya di awal dan perlu mengeksplorasi dan menemukan tindakan yang tepat di kanan situasi dari waktu ke waktu. Jadi, itu mungkin merusak atau melakukan tindakan yang sangat tidak aman selama proses pembelajaran.Kami juga akan membuat model pembelajaran menjadi sangat kuat dengan menerapkan gaya secara acak selama

proses pelatihan. Jadi, model yang kokoh dapat digunakan dalam robot nyata dan mengadopsi dirinya dengan model dinamis baru. Solusi yang kami usulkan mengatasi semua tantangan yang disebutkan dalam tabel 1.1 untuk masalah khusus ini.

Kami akan menggunakan sensor di bagian atas pendulum terbalik untuk merasakan kecepatan sudut dan orientasi pendulum terbalik, data ini digunakan sebagai masukan untuk algoritma pembelajaran. Kami menggunakan teknik fusi sensor untuk membuat sensor ini dan dijelaskan secara rinci tentang perangkat keras.

Machine Learning (ML) telah menarik lebih banyak perhatian saat ini dan banyak ditemukan aplikasi di setiap sektor industri, mulai dari pengenalan pola data besar hingga otomatisasi dan hiburan. Ini memainkan peran penting dalam bidang medis seperti jantung, hati, dan kanker sistem deteksi dini. ML telah membuka jalan untuk membiayai dan bisnis juga dan memungkinkan pendekatan berbasis data yang lebih baik, dari prediksi saham hingga keuangan. Pembelajaran mesin algoritma semakin ditingkatkan dan dikembangkan, metode dan algoritma baru muncul setiap hari.

Teknologi ML memungkinkan pergeseran paradigma dalam pemecahan masalah dari analitis menjadi kuat pendekatan berbasis data. Unit pemrosesan berkecepatan tinggi, ketersediaan data besar dan data berlabel,memungkinkan program komputer mempelajari model dari data pelatihan dan memprediksi hasil dari yang baru Kategori utama pembelajaran mesin adalah:

• Pembelajaran yang diawasi

• Pembelajaran tanpa pengawasan

• Pembelajaran yang diperkuat

Algoritma Deep Reinforcement Learning

1. Reinforcement learning

Reinforcement Learning adalah kelas model machine Learning dimana proses pembelajaran didasarkan pada umpan balik evaluatif tanpa ada siyal yang diawasi. Reinforcement learning tidak memerlukan data sebelumnya dan bisa secara mandiri mendapakan kebijakan opsional dengan pengetahuan yang diperoleh dengan trial-and kesalaha dan terus berinteraksi dengan lingkungan yang dinamis. Kerangka matematis untuk menentukan solusi dala skenario pembelajaran penguatan adalah disebut Proses Keputusan Markov. Ini dapat dirancang sebagai :

A. S: Set of State

B. A: Set of Action

C. R: Reward functiom

D. Π:Policy

E. V: Value

Agen mengambil tindakan (A) untuk transisi dari status awal ke status akhir (S) dan masuk kembali, mendapat hadiah (R) untuk setiap tindakan, tindakan mengarah pada hadiah positif atau negatif penghargaan. Serangkaian tindakan yang diambil Agen, tentukan (π)dan imbalan yang didapatnya kembali, mendefenisikan niai V. Tugas disini adalah memaksimalkan imbalan dengan memilih kebijakan yang tepat. Jadi, kita harus memaksimalkan semua kemunngkinan nilai S untuk waktu t yang dapat dilihat pada pesemaan 2.!, dimana (π)adalah kebikjakan, r adalah reward dan S adalah state dan E adalah fungsi yang harus dimaksimalkan.

E = ( rt / π.St )

2. Q Learning

Q-learning adalah algoritme pembelajaran penguatan di luar kebijakan dan bebas model. di luar kebijakan metode mengevaluasi atau meningkatkan kebijakan yang berbeda dari yang digunakan untuk menghasilkan data, di Kontras Metode on-policy mencoba untuk mengevaluasi atau memperbaiki kebijakan yang digunakan untuk membuat keputusan. Dalam model algoritma tipe bebas RL tidak membuat asumsi model dinamis lingkungan.

‘Q’ dalam Q-Learning berarti kualitas. Kualitas dalam hal ini mempresentasikan seberapa berguna suatu pemberian tindakan adalah untuk mendapatkan beberapa hadiah di masa depan. Dalam Q-Learning kita membuat Q-table yang representatif nilai kualitas dari setiap keadaan. Untuk menjelaskan secara singkat cara kerja Q-Learning, Izinkan asumsikan robot harus melewati labiirin dan mencapai titik akhir tetapi ada beberapa rajau dan tingkatkan poin di area tersebut.

Table-Q terdiri dari empat tinndakan dalam 4 kolom dan 5 status dalam 5 baris. Daalam contoh ini. Tabel ini pertama kali diinisialisasi dengan nilai 0 tetapi kemudian menggunkan Persamaan Bellman.

V(s) = max ( R((s,a) + yV (s’)

Keterangan :

S = a particular state

a = action

S’= state to which the robot goes from s

Y= discount factor

R((s,a) = a reward function which takes a state s and action a and outputs a reward value

V (s) = value of being in a particular state

Persmaan Bellman dalam bentuk sederhana mengatakan nilai Q saat ini sebagian besar terkait dengan imbalan langsung ditambah sebagian dari imbalan masa depaa. Algoritma keseluruhan untul Q-learning bisa dilihat pada gambar.

3. Deep Q learning

Setelah makalah DeepMind diterbitkan pada 2015 “Kontrol tingkat manusia melalui kedalaman pembelajaran penguatan , Kombinasi jaringan saraf tiruan dengan pembelajaran penguatan membuka cakrawala baru untuk robot otonom. Gambar dibawah menunjukan perbedaan antara Q Learning dan Deep Q Learning secara sederhana masalah, nilai Q diperkirakan untuk setiap tindakan dengan Neural Network dan memperkirakan nilai Q. Dengan pendekatan ini kita menimilkan jumlah kebutuhan memori. Namun, pendekatan ini memaksakan beberapa yang lain masalah juga.

Untuk menerapkan pembelajaran penguatan dalam sistem pendulum terbalik yang paling kompleks, kami telah membagi studi kasus menjadi 3 bagian. Kita mulai dengan kebebasan satu derajat pendulum terbalik yang terutama digunakan dalam makalah yang diterbitkan baru-baru ini, fase ini memungkinkan kita untuk melakukannya periksa dan bandingkan hasil kami dengan yang dipublikasikan, temukan kesalahan kami dan selesaikan semuanya tantangan untuk langkah selanjutnya.

Kemudian kita mengambil langkah lebih jauh dan membuat pendulum terbalik 3 derajat kebebasan di mana pendulum terbalik dapat jatuh bebas ke segala arah. Untuk mengontrol sistem ini, kami menempatkannya pada beberapa orang sasis yang dapat bergerak bebas ke segala arah. Kami mencoba mengembangkan seluruh program di sedemikian rupa sehingga memperluas proyek dari satu fase ke fase lainnya tidak memerlukan re menyusun keseluruhan program. Kami menggunakan kelas yang ditulis dalam bahasa Python, perpustakaan dan file konfigurasi untuk memungkinkan kami dengan cepat mengubah satu program ke program lainnya.

Pendulum terbalik satu derajat garis lurus lurus terdiri dari gerobak atau a kotak yang bergerak hanya dalam satu sumbu dan tiang yang digantung di tengahnya dan di mana berayun bebas pada sumbu yang sama dengan gerobak atau kotak bergerak. Seperti yang terlihat pada gambar 10 gaya F adalah diperlukan untuk menggerakkan gerobak ke kiri dan ke kanan dan berdasarkan percepatan, kecepatan, dan kecepatannya posisi pendulum terbalik bisa berayun ke kiri atau ke kanan juga. Tujuannya adalah dengan menggerakkan gerobak (kotak coklat), pertahankan sudut ÿ sekecil mungkin.

Mengimplementasikan algoritma pembelajaran penguatan yang dapat berinteraksi dengan Gazebo lingkungan kami menggunakan bahasa Python 3.7 dengan beberapa dependensi dan perpustakaan, beberapa di antaranya library utama yang digunakan dalam pemrograman adalah numpy, rospy, openai_ros, tensorflow.

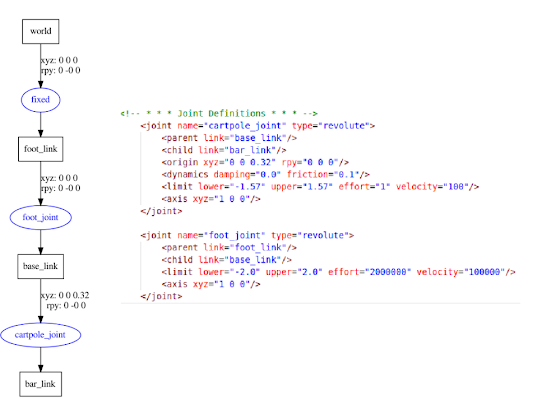

Kami juga telah menggunakan rilis terbaru algoritme DQN dari baseline OpenAI. Kami telah melakukan beberapa perubahan dalam lingkungan cartpole OpenAI_ROS yang ada untuk memfasilitasi menggunakan kembali kode di tahap selanjutnya dan lingkungan yang lebih rumit. Program ini terdiri dari 3 skrip utama:

• The "Robot Script" yang menangani komunikasi dengan cartpole kembali dan

sebagainya untuk mendapatkan data IMU untuk kecepatan sudut, pitch, dan roll, dan kecepatan pengiriman

perintah ke cartpole

• "Skrip Tugas" yang menangani penghitungan hadiah, mengumpulkan pengamatan,

menghasilkan tindakan dan inisialisasi simulasi setelah setiap episode pelatihan.

• "Skrip Utama" yang memuat algoritme DQN dasar dan mengatur semua parameter.

3 skrip ini ditulis dalam bentuk kelas dan bahasa Python dan mewarisi semua data dan fungsi

dari satu orang ke orang lainnya. OpenAI_ROS adalah versi OpenAI_Gym yang sangat membantu implementasi algoritma RL untuk studi kasus ini [20]. Struktur keseluruhan dari

tampilan program pada gambar 3.5. Kami mempertimbangkan dua faktor untuk fungsi penghargaan dari pembelajaran penguatan, salah satunya adalah sudut tiang yang datang dari sensor di atas dan yang lainnya adalah posisi gerobak yang bergerak kekiri atau ke kenan. Setiap kali tindakan diberikan ke sistem kemudian hadiah dihitung, dan kami memeriksa apakah kami harus mengatur ulang lingkungan ke tahap awal atau melanjutkan belajar.

Persamaan 3.1 menunjukan fungsi hadiah, sudut dapat bervariasi dari -1,57 hingga =1,57 radian sebagai per sifat fisik jadi hadiah terbaik adalah ketika tiang tepat di posisi vertikal, posisi gerobak deapat bervariasi dari -2,5m hingga =2,5m sehingga hadiah terbaik diberikan saat gerobak berada dekat dengan pusat. Kami menggunakan cosinus dari dua input termasuk bobot untuk menghitung total penghargaan. Lebih berat dipertimbangkan untuk menjaga tiang dalam poisis vertikal daripada berada di luar zona.

Kami juga memiliki fungsi batas lain untuk mendeteksi kapan lingkungan diatur ulang untuk memulai kembali apisode berikutnya, fungsi ini memeriksa batas sudut tiang dan posisi gerobak. Jika poisis gerobak lebih dari 2 meter dari pusat atau sudut tiang melebihi 0,35 radian maka kami anggap gagal dan enviroment harus direset, pembelajaran masih belanjut sampai langkah dan episode total yang ditentukan mencapai atau penyelesaian masalah yang mencapai 300 hadiah sebagai kuadrat rata rata.

Untuk keluaran ke lingkungan atau tindakan simulasi, kami mempertimbangkan 2 tindakan untuk ditinggalkan kecepatan atau mengurangi kecepatan. Kecepatan negatif berarti hanya kecepatan ke arah lain. Setelah menjalankan program semua node dan koneksi diperbarui dan dapat dilihat pada gambar 3.6. Cartpole_gym adalah simpul yang dibuat oleh program pelatihan utama, menerima joint menyatakan dan data IMU dan kemudian menghasilkan perintah kecepatan, perintah hanya menerbitkan data pada topik yang lain yang diterima oleh lingkungan Simulasi Gazebo. Menggunakan ROS memungkinkan kita dengan kita dengan cepat beralih dari lingkungan simulasi ke robot nyata hanya dengan mengubah IP sistem Gazebo ke lingkungan fisik aktual.

PROGAM (Keseimbangan Inverted Pendulum)

URDF SIMULASI INVERTED PENDULUM PADA ROS

Link Donwload[kembali]